| EN BREF |

|

Le crawl, une technique essentielle en exploration de données, permet de collecter de manière automatisée des informations précieuses sur le web. À travers le processus de crawling, ces robots explorateurs naviguent parmi les pages web en suivant des liens, récoltant ainsi une multitude de données qui seront ensuite traitées et classifiées. En utilisant les rapports d’exploration de la Google Search Console, on peut optimiser cette collecte pour une analyse précise des structures de sites, permettant ainsi d’affiner sa stratégie SEO et d’améliorer la visibilité en ligne. La compréhension de la profondeur et des signaux de crawl est cruciale pour maximiser l’effet de cette exploration automatisée et élargir notre champ d’analyse en matière d’indexation de contenu.

Dans le vaste univers du web, le crawl demeure un outil essentiel pour l’exploration de données. Cette pratique consiste à automatiser la collecte d’informations depuis diverses pages web pour ensuite les analyser et les utiliser de manière stratégique. Cet article vous guidera à travers les concepts fondamentaux du crawling, expliquera comment optimiser le processus via divers outils et techniques, et explorera son rôle crucial dans le domaine du SEO et plus particulièrement, du Black Hat SEO.

Les Fondamentaux du Crawl

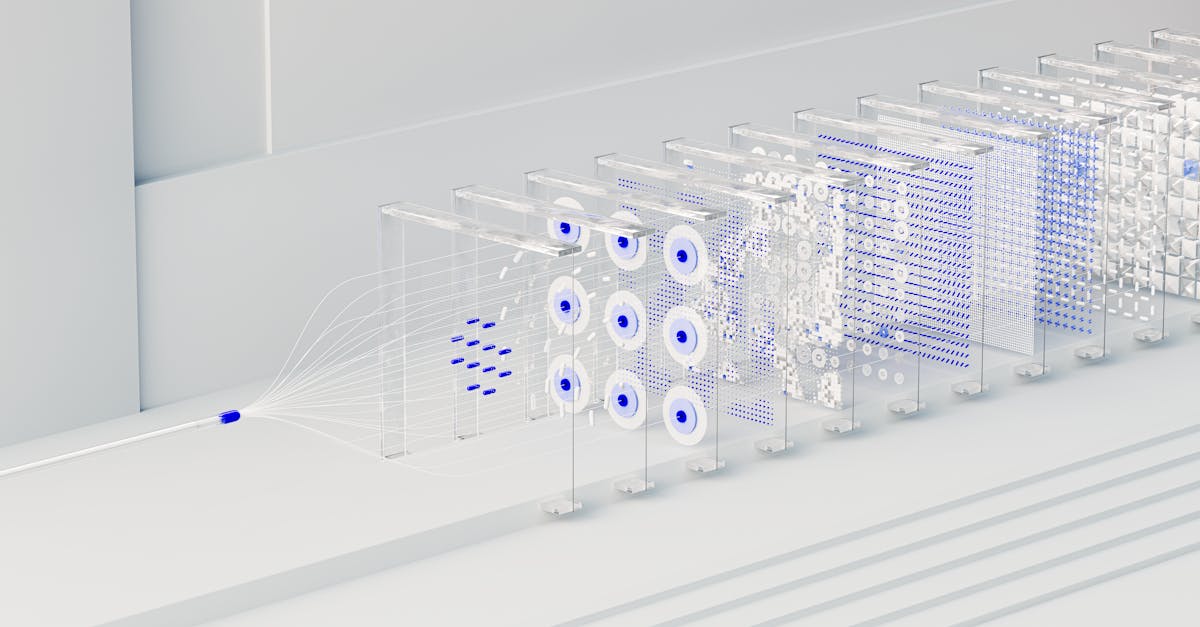

Le crawling est une technique de collecte automatisée d’informations sur le web. Des robots, souvent appelés « crawlers » ou « spiders », parcourent les sites en suivant les liens pour extraire le contenu des pages. Ce processus est au cœur des moteurs de recherche, qui explorent ainsi l’intégralité du web, indexant ce qu’ils trouvent pour fournir des résultats de recherche pertinents. Plus encore, pour les entreprises, l’analyse des données de crawl peut révéler des schémas de navigation des utilisateurs et des tendances de recherche.

Optimiser votre Stratégie de Crawl

Pour bien utiliser le crawl dans l’exploration de données, il est nécessaire d’optimiser votre stratégie. Les outils tels que la Google Search Console sont indispensables pour surveiller et analyser les rapports d’exploration de votre site web. En maîtrisant le budget de crawl, qui représente le nombre maximum de pages qu’un moteur de recherche peut parcourir, vous garantissez une meilleure visibilité pour les pages clés de votre site. Pour maximiser l’efficacité, il est recommandé d’optimiser votre fichier robots.txt.

L’Impact du Crawl sur le SEO

L’importance du crawl pour le SEO, surtout en Black Hat SEO, ne peut être sous-estimée. Les robots d’exploration jouent un rôle crucial dans l’indexation de vos pages, ce qui influence directement votre classement dans les moteurs de recherche. Par ailleurs, le crawl est essentiel pour détecter et gérer les problèmes de contenu dupliqué. Découvrez davantage d’informations sur comment le crawl impacte le contenu dupliqué.

Utilisation du Crawl pour le Black Hat SEO

Bien que controversé, le Black Hat SEO utilise des techniques de crawl pour manipuler les moteurs de recherche en faveur de leur stratégie de contenu. Ce domaine utilise fréquemment des méthodes de contournement pour influencer les résultats de recherche. Pour en savoir plus sur ces techniques, visitez notre guide sur les techniques de contournement du crawl.

Explorer l’Architecture de Site par le Crawl

Analyser l’architecture de votre site grâce au crawl permet de découvrir comment les moteurs de recherche perçoivent votre site. Cela inclut des éléments tels que la profondeur de crawl, qui affecte directement votre stratégie SEO. Ainsi, en surveillant les erreurs de crawl et en ajustant votre structure, vous optimisez non seulement l’accessibilité de votre site aux robots d’exploration, mais aussi l’expérience utilisateur.

Le crawl, bien que souvent associé à l’optimisation pour les moteurs de recherche (SEO), offre une richesse d’applications dans le domaine de l’exploration de données. Cet article explore comment cette technique automatisée de collecte de données permet d’obtenir des informations cruciales et comment elle peut être utilisée de manière stratégique pour analyser des sites web et améliorer la prise de décision en entreprise. Nous aborderons les méthodes et les techniques du crawl, ainsi que son importance pour le traitement des données structurées et non structurées, tout en touchant à son rôle dans le SEO, notamment en contexte de stratégie Black Hat SEO.

L’Essence du Crawl pour l’Exploration de Données

Le crawl est une activité clé pour l’automatisation de la collecte de données. En utilisant des robots d’exploration, il est possible de parcourir des pages web et d’extraire des informations de valeur, connues sous le nom de crawling et scraping. Ces robots suivent les liens entre les pages pour faire remonter des données essentielles, permettant de comprendre la structure d’un site ou de compiler des données pertinentes pour l’analyse. Cette capacité à parcourir de manière efficace un vaste ensemble de contenus devient de plus en plus cruciale dans le traitement des big data.

Techniques de Crawling et Sélection des Données

Il existe diverses méthodes et techniques pour crawler un site web. La première étape consiste à comprendre comment les moteurs de recherche utilisent ces robots d’exploration pour indexer des pages. En adoptant des stratégies avancées, comme celles explorées dans le black hat SEO, on peut ainsi mieux s’approprier les mécanismes d’exploration pour un maximum d’efficacité. Par ailleurs, le contrôle de la profondeur de crawl permet aux experts de désigner jusqu’où le crawler doit aller, assurant ainsi une finesse dans la sélection des données extraites.

Optimisation du Crawl pour les Grandes Structures

Pour optimiser l’exploration de sites web volumineux, notamment ceux qui sont fréquemment mis à jour, la gestion du budget d’exploration est un paramètre de taille. Ce budget comprend le nombre maximal de pages qu’un robot peut parcourir lors d’une session donnée, influençant directement le volume de données collecté. En gérant correctement ces ressources limitées, on maximise l’efficacité des robots, même sur les sites disposant de nombreuses pages à forte dynamique.

Utilisation du Crawl dans une Stratégie SEO

Dans le cadre du SEO, le crawl joue un rôle déterminant. Il ne s’agit pas seulement de rendre un site « crawlé », mais bien de l’optimiser pour qu’il se révèle pertinent aux yeux des moteurs de recherche. Par exemple, en veillant à ce qu’une architecture de site soit logique et que les redirections soit optimisées, on influence directement le classement de ce dernier, comme souligné ici. De plus, l’utilisation efficace de la Google Search Console permet de surveiller et résoudre des problèmes spécifiques liés au crawl pour maintenir les performances SEO.

Pratiques à Éviter et Surveiller les Résultats

Bien que le crawling offre de nombreux avantages, il est essentiel d’éviter certaines erreurs courantes qui pourraient affecter négativement les résultats. Des pratiques mal contrôlées peuvent par exemple mener à un surplus de charges serveur ou à des pénalités Google. Ainsi, la surveillance continue du crawl est cruciale pour mesurer l’efficacité de sa stratégie et apporter les ajustements nécessaires en temps opportun.

Dans un monde où le crawling est au cœur de l’exploration de données, comprendre comment utiliser cette technique efficacement est crucial. Il s’agit d’un processus qui permet de collecter automatiquement des données à partir de pages web, de les classer et de les indexer. En adoptant une stratégie bien pensée, vous pouvez exploiter le crawl pour maximiser la récolte d’informations pertinentes, améliorer votre SEO et optimiser la structure de votre site web. Cet article vous guide à travers les différentes étapes de la mise en place d’une stratégie de crawl efficace.

Comprendre les Fondamentaux du Crawl

Le concept de crawling repose sur l’utilisation de robots, souvent appelés crawlers ou spiders, qui explorent le Web en suivant des liens entre les pages. Cette technique est essentielle pour les moteurs de recherche, leur permettant de trouver et d’indexer des pages web. En comprenant cet aspect fondamental, vous pouvez mieux structurer votre site pour améliorer l’accessibilité et la visibilité de vos pages.

Utilisation Stratégique du Crawl pour l’Exploration de Données

Exploiter le crawl dans l’exploration de données commence par la définition claire de vos objectifs. Avez-vous besoin d’informations spécifiques sur la structure de votre site ou cherchez-vous à analyser les performances de votre SEO? Une fois ces objectifs en place, vous pouvez choisir les méthodes et outils de crawl qui répondent le mieux à vos besoins.

Optimiser le Budget d’Exploration

Pour les sites volumineux, la gestion du budget d’exploration est cruciale afin de maximiser l’efficacité du crawl. Il est essentiel de prioriser l’exploration des pages les plus importantes et de mettre en place un fichier robots.txt optimisé pour guider les crawlers de manière stratégique. Des outils comme Google Search Console offrent des rapports d’exploration précieux pour surveiller et ajuster votre stratégie.

Techniques Avancées et Risques Liés au Black Hat SEO

Bien que le crawling soit souvent associé à des pratiques SEO légitimes, certaines techniques de Black Hat SEO utilisent le crawl de manière controversée. Il est impératif de connaître ces pratiques et d’éviter les erreurs de crawl qui pourraient nuire à votre référencement. Pour plus de détails sur ces techniques et comment les éviter, visitez cet lien.

Mesurer l’Efficacité de Votre Stratégie de Crawl

La dernière étape de votre stratégie consiste à évaluer les résultats obtenus grâce au crawl. Pour cela, il est essentiel de croiser les données de crawl avec d’autres formes de données, comme les logs de serveur. Cette combinaison offrira une vue complète et détaillée de votre site, permettant d’identifier les zones à améliorer pour mieux accueillir les robots d’exploration et, par conséquent, les utilisateurs.

L’Impact du Crawl dans l’Exploration de Données

Le crawl occupe une place prépondérante dans le domaine de l’exploration de données, offrant une méthode automatisée et efficace pour la collecte de vastes quantités d’informations sur le Web. En utilisant des techniques avancées de crawling, les données peuvent être extraites à des niveaux de profondeur variés, permettant une compréhension approfondie de la structure d’un site. Cela se révèle particulièrement utile pour les entreprises cherchant à optimiser leur visibilité en ligne, car une architecture de site bien balancée favorise une meilleure indexation par les moteurs de recherche.

En outre, le crawling joue un rôle essentiel dans l’amélioration des stratégies SEO. Il permet aux spécialistes de détecter et de corriger les erreurs techniques qui pourraient impacter l’accessibilité ou la performance d’un site. Grâce à l’analyse régulière de données de crawl, il devient possible de surveiller continuellement les infrastructures numériques en place, évitant ainsi les pénalités dues à des problèmes tels que le contenu dupliqué ou des redirections inefficaces.

La collecte automatisée de données par le biais du crawl offre aussi une vue à jour des tendances et des changements dans la convivialité du site. Une gestion judicieuse du budget de crawl est cruciale pour s’assurer que les sites volumineux ou fréquemment mis à jour ne saturent pas les ressources des moteurs de recherche. À cet égard, les outils tels que Google Search Console sont indispensables pour optimiser ces processus, permettant une surveillance et un ajustement en temps réel des flux d’exploration.

Finalement, intégrer le crawl dans des initiatives plus larges telles que l’analyse de logs peut donner un aperçu inestimable sur la manière dont les visiteurs interagissent avec le contenu numérique. Cela ouvre la voie à des stratégies de contenu plus efficaces et à une expérience utilisateur raffinée, augmentant ainsi le trafic organique et favorisant une position plus concurrentielle dans l’écosystème numérique.

FAQ : Utilisation du Crawl pour l’Exploration de Données

Q : Qu’est-ce que le crawling dans le contexte de l’exploration de données ?

R : Le crawling est un processus automatisé qui consiste à collecter le contenu d’une page web en suivant les liens, pour ensuite traiter et classer ces données. Il permet d’extraire un maximum d’informations sur la structure d’un site, ce qui est essentiel pour l’exploration de données.

Q : Pourquoi le crawl est-il important pour le SEO ?

R : Le miroir de la toile du crawl permet aux moteurs de recherche d’accéder aux pages web et de les indexer, ce qui est crucial pour leur classement SEO. En optimisant le crawl de votre site, vous pouvez améliorer votre visibilité dans les résultats de recherche.

Q : Comment fonctionne le processus de crawling ?

R : Les robots d’exploration ou crawlers naviguent sur le Web en suivant les liens entre les pages. Ils recueillent des données importantes pour les moteurs de recherche, notamment le contenu des pages, les liens entrants et sortants, et d’autres métadonnées.

Q : Quels sont les avantages du crawl pour l’analyse de données ?

R : Le crawl permet d’accéder à une grande quantité de données qui peuvent ensuite être analysées pour en dégager des tendances, éclairer sur la structure d’un site et influencer la stratégie de contenu.

Q : Comment l’utilisation du crawl affecte-t-elle l’expérience utilisateur ?

R : En optimisant le crawl, vous pouvez identifier et corriger les problèmes structurels de votre site, améliorer le temps de chargement des pages et l’accessibilité, ce qui améliore l’expérience utilisateur globale.

Q : Quelle est l’importance du budget de crawl ?

R : Le budget de crawl est le nombre maximum de pages qu’un moteur de recherche peut explorer sur un site pendant une période donnée. Il est crucial de l’optimiser, surtout pour les sites volumineux, afin de garantir que les pages importantes sont correctement indexées.

Q : Comment le crawl peut-il être utilisé pour résoudre des problèmes d’indexation ?

R : En utilisant des outils comme la Google Search Console, vous pouvez analyser les données de crawl pour identifier et corriger les erreurs d’indexation, assurant ainsi que votre site est bien représenté dans les résultats de recherche.

Q : Que signifie la profondeur de crawl ?

R : La profondeur de crawl désigne le niveau auquel un crawler explore un site web. Une profondeur excessive peut signifier que certaines pages sont inaccessibles aux moteurs de recherche, affectant ainsi leur indexation.

Q : Comment peut-on optimiser le fichier robots.txt pour le crawl ?

R : Le fichier robots.txt guide les crawlers sur les pages à explorer et celles à éviter. Une configuration optimisée garantit que les robots d’indexation se concentrent sur les pages qui ont le plus de valeur pour le SEO.

Q : Quelles sont les erreurs de crawl courantes à éviter ?

R : Parmi les erreurs de crawl courantes, on trouve les pages non accessibles, les redirections incorrectes et une mauvaise configuration du fichier robots.txt. Éviter ces erreurs est essentiel pour un bon référencement.